Яндекс о дублях на сайте: как обнаружить, и что с ними делать

Команда Яндекса в блоге для вебмастеров рассказала о вреде дублей на сайте, как их обнаружить, и что с ними делать.

Дубли – это страницы сайта с одинаковым или практически полностью совпадающим контентом. Наличие таких страниц может негативно сказаться на взаимодействии сайта с поисковой системой.

Дубли могут замедлять индексирования нужных страниц и затрудняют интерпретацию данных веб-аналитики.

Дубли могут появиться на сайт в результате:

- Автоматической генерации. Например, CMS сайта создает ссылки не только с ЧПУ, но и техническим адресом: https://site.ru/noviy-tovar и https://site.ru/id279382.

- Некорректных настроек. К примеру, при неправильно настроенных относительных ссылках на сайте могут появляться ссылки по адресам, которых физически не существует, и они отдают такой же контент, как и нужные страницы сайта.

- Ссылок с незначащими GET-параметрами. Подробнее об этом можно посмотреть тут).

- Ссылок со слешем на конце и без. Для поисковой системы сайты https://site.ru/page и https://site.ru/pages/ – это разные страницы (исключение составляет только главная страница, между https://site.ru/ и https://site.ru разницы нет).

Как обнаружить дубли

В разделе «Диагностика» появилось специальное уведомление, которое расскажет про большую долю дублей на сайте. Алерт появляется с небольшой задержкой в 2-3 дня – это обусловлено тем, что на сбор достаточного количества данных и их обработку требуется время.

Подписываться на оповещения не нужно, уведомление появится само.

Чтобы найти дубли вручную, нужно:

- перейти в Вебмастер;

- во вкладке «Индексирование» открыть «Страницы в поиске»;

- нажать на «Исключенные» в правой части страницы;

- прокрутив вниз, в правом нижнем углу найти опцию «Скачать таблицу»;

- выбрать подходящий формат и загрузить архив. У страниц-дублей будет статус DUPLICATE.

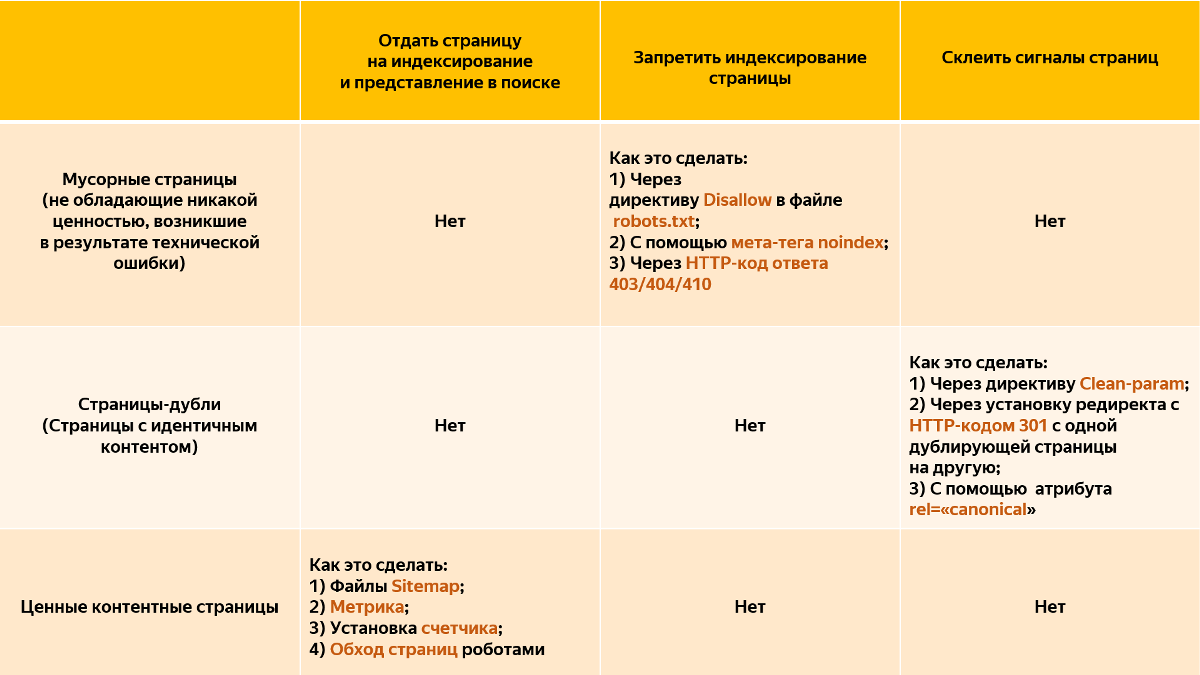

Как оставить в поиске нужную страницу в зависимости от ситуации

В случае с «мусорными» страницами Яндекс рекомендует воспользоваться одним из способов:

- Добавить в файл robots.txt директиву Disallow, чтобы запретить индексирование страницы-дубля;

- Либо запретить их индексирование при помощи мета-тега noindex. Тогда поисковой робот сможет исключить страницы из базы по мере их переобхода;

- Если такой возможности нет, можно настроить HTTP-код ответа 403/404/410. Данный метод менее предпочтителен, так как показатели недоступных страниц не будут учитываться, и если где-то на сайте или в поиске еще есть ссылки на такие страницы, пользователь попадет на недоступную ссылку.

В случае со страницами-дублями можно воспользоваться одним из способов:

- Для дублей с незначащими GET-параметрами добавить в файл robots.txt директиву Clean-param. Директива Clean-param – межсекционная. Это означает, что она будет обрабатываться в любом месте файла robots.txt. Указывать ее для роботов Яндекса при помощи User-Agent: Yandex не требуется;

- Установить редирект с HTTP-кодом 301 с одной дублирующей страницы на другую. В этом случае в поиске будет участвовать цель установленного редиректа. Важно указать предпочитаемый (канонический) адрес страницы, который будет участвовать в поиске;

- Использовать атрибут rel=«canonical». При работе с атрибутом rel=«canonical» стоит учитывать, что если содержимое дублей имеет некоторые отличия или очень часто обновляется, то такие страницы все равно могут попасть в поиск из-за различий в этом содержимом. В этом случае рекомендуется использовать другие предложенные варианты.

Для страниц со слешем на конце и без рекомендуется использовать редирект 301. Можно выбрать в качестве доступной как ссылку со слешем, так и без него – для индексирования разницы никакой нет.

В случае с важными контентыми страницами для их индексирования и представления в поиске важно использовать:

- Файлы Sitemap;

- Метрику;

- Установку счетчика;

- Настройку обхода страниц роботами.

Подробные рекомендации о работе со страницами-дублями читайте в Справке.

Источник: Блог Яндекса для вебмастеров

Источник: seonews.ru