Как продвигать сайт — внешняя и пользовательская оптимизация

Это завершающая публикация из серии посвященной проблеме, которая часто возникает у начинающих вебмастеров сразу после того, как они начали работу над своим проектом — как продвинуться и поднять посещаемость.

Данная проблема не имеет простого и быстрого решения, но при должном использовании имеющихся у вебмастера инструментов, влияющих на отношение к сайту поисковых систем, можно получить очень неплохие показатели и приличную посещаемость.

Все, о чем я писал в двух предыдущих статьях (Как продвигать сайт — SEO или реклама н и Как продвигаться за счет внутренней оптимизации, а третью часть вы читаете в данный момент), которые, надеюсь, помогут вам, было применено мною на практике и за полтора года развития KtoNaNovenkogo.ru. Надеюсь, что мой опыт вам пригодится.

Как продвигать сайт ссылками (внешняя оптимизация)

Итак, внешняя оптимизация. Что это такое, зачем нужно и как провести ее бесплатно? Обычно в такой последовательности в голове начинающих вебмастеров и оптимизаторов возникают вопросы по поводу внешней поисковой оптимизации.

Наверное, из самого названия понятно, что данный вид поисковой оптимизации проводится не на самом сайте, а из вне. А заключается он в проставлении на свой горячо любимый ресурс, который нужно продвигать, как можно большего количества обратных ссылок.

Давайте сначала попробуем понять, а почему поиск уделяет такое внимание обратным ссылкам. Все дело в том, что когда-то на заре интернета основным фактором, влияющим на успешное продвижение, была внутренняя оптимизация.

Но, как вы сами понимаете, многие стали всеми доступными способами накручивать плотность вхождения ключевых слов и другие факторы, поэтому поисковым системам пришлось задействовать дополнительный фактор, который будет влиять на ранжирование — бэклинки.

Поисковики справедливо рассудили, что если кто-то ссылается на другой сайт, то это сравнимо с отданным голосом и таким образом можно проводить ранжирование, принимая во внимание не только сам факт наличия обратной ссылки, но и тот текст, который в ней используется — анкор (тут вы вы можете найти подробное описание влияния статического и динамического веса, а также принципы формирования анкор-листов). Тем более, что повлиять на этот фактор оптимизаторам будет сложнее, нежели переоптимизировать текст на собственном ресурсе.

Но все это было справедливо до поры до времени, пока продажа ссылок не стала очень доходным бизнесом и все это не было поставлено на поток (ссылочные биржи, агрегаторы, позволяющие осуществлять закупку в автоматическом режиме и многое другое). Сейчас ссылочное ранжирование (определение соответствия продвигаемой страницы запросу на основе анкоров обратных ссылок ведущих на нее) тоже сильно заспамлено и не может использоваться поиском как основной критерий.

Поисковики вынуждены были искать новый способ определения релевантности (об этом понятии я уже писал, а также и про ранжирование). При этом они опять же совершенно справедливо посчитали, что можно будет спросить самих пользователей о пользе того или иного ресурса — т.е. использовать новый фактор ранжирования.

Продвигать сайт с учетом пользовательских факторов стало своеобразным трендом на сегодняшний день, но и два других влияющих на ранжирование (внутренние и внешние факторы) тоже не утратили своей актуальности, и сейчас можно говорить о триумвирате в области продвижения. Хотя, конечно же, реальных факторов, учитываемых поисковыми системами при ранжировании документов (веб страниц), очень много, но все их можно свести или упростить до этих трех основных, которые мы и будет рассматривать.

Итак, давайте не будем нарушать последовательность появления факторов ранжирования на арене поискового продвижения и начнем с так называемых ссылочных или, по другому говоря, с внешней поисковой оптимизации. Любому ресурсу, который продвигается, нужно набрать как можно большее количество обратных ссылок, которые оптимизаторы называют ссылочной массой. Она может быть разной и ее влияние на позиции сайта в выдаче будет определяться не только и не столько ее количеством, сколько качеством.

Поисковики сейчас уже довольно четко и с высокой долей вероятности научились определять и отделять от общей ссылочной массы те ссылки, которые были вами куплены. Однако они их по-прежнему учитывают, но вот тот вес, с которым они учитываются, будет сильно зависеть как от качества ссылающегося ресурса, так и от качества вашего собственного проекта.

Также, продвигая сайт в современных условиях и реалиях, можно будет закупиться настолько неудачными ссылками, которые в результате передадут вашему ресурсу отрицательный траст, что приведет к проседанию сайта по всем запросам в поисковой выдаче (траст означает степень доверия поисковой системы к вашему ресурсу, но конкретной единицы его измерения, которую можно было померить, увы, нет, но можно его приблизительно оценить в сервисе XTools).

Профессиональные оптимизаторы при закупке ссылок используют накопленные на собственном опыте черные и белые списки сайтов, с которых можно или нельзя покупать, но начинающему вебмастеру разобраться во всех этих перипетиях будет довольно сложно, да и по большому счету не нужно, ибо существуют способы обойтись вовсе без покупки обратных ссылок, но при этом не получить баранку в графе внешней оптимизации.

Я говорю о бесплатных способах получения обратных ссылок, про которые уже неоднократно писал, да и планирую писать дальше. Совсем недавно я рассказывал про то, Как раскрутить сайт средствами внешней оптимизации, где приводил список популярных каталогов, куда можно будет добавить свой ресурс и список RSS агрегаторов.

Кроме этого для поиска мест, откуда можно будет бесплатно получить обратную ссылку на свой сайт, вы можете воспользоваться довольно большим количеством материалов из раздела Где взять внешние ссылки.

Продвигая свой проект с помощью описанных мною бесплатных способов, вам нужно учитывать, что нет никакого смысла получать более одной внешней ссылки с одного и того же ресурса (во всяком случае для Яндекса).

Также следует знать, что в случае безанкорных ссылок (они не имеют текста, например, https://ktonanovenkogo.ru), поисковые системы могут учесть в качестве анкора текст, расположенный справа или слева от гиперссылки, поэтому заполняя профиль на трастовых сайтах используйте различные поля для ввода тематичного околоссылочного текста.

Тексты анкоров уже не имеют столь глобального значения как было до недавнего времени, но тем не менее по ним также будет осуществляться ранжирование и определяться релевантность продвигаемой страницы вашего ресурса ключевым словам поискового запроса. Поэтому, по возможности, используйте в анкоре ключевые слова, по которым продвигается страница, на которую ведет эта ссылка. О том, как разбавлять анкоры, читайте в приведенной выше статье.

Еще одной особенностью бесплатных способов получения обратных ссылок является то, что большинство из них будет вести на главную страницу вашего ресурса, тем самым накачивая ее статическим весом. Но при грамотной и всеобъемлющей внутренней перелинковке этот статический вес будет достаточно равномерно распределяться по внутренним страницам, позволяя им занимать более высокие позиции в выдаче по тем запросам, под которые они были оптимизированы (обычно это НЧ и изредка СЧ).

Главная задача, которую мы преследуем набирая ссылочную массу с помощью бесплатных ссылок с качественных ресурсов, это наращивание и повышение траста собственного сайта. Хотя многие начинающие вебмастера больше склонны думать, что главная задача и цель — увеличение ТИЦ (тематического индекса цитирования Яндекса), о котором мы говорили тут.

Но Тиц оказывает гораздо меньшее влияние на то, как успешно будет продвигаться ваш сайт и насколько высокая у него будет посещаемость (он скорее является следствием успешного продвижения, нежели его причиной). Именно повышение траста ведет к существенному увеличению посещаемости, т.к. в этом случае проект поднимается по всем запросам в поисковых выдачах, под которые вы его оптимизировали.

Это очень серьезный аргумент для того, чтобы попытаться повысить трастовость своего ресурса, хотя бы за счет обратных ссылок с профилей и блогов, а про Тиц можно забыть, если вы только не зарабатываете на продаже ссылок в биржах подобных:

Да, чуть не забыл сказать, что для удержания максимально возможного статического веса внутри сайта нужно будет закрыть от индексации поисковыми системами все внешние ссылки, в открытии которых нет особой необходимости. Я вообще советую закрыть абсолютно все, открывая только некоторые из них по необходимости.

И дело тут даже не только в утекании статического веса, но и в том, что внешние ссылки из комментариев могут вести на плохие с точки зрения поисковиков ресурсы, что в свою очередь может очень сильно навредить вашему проекту, ибо раз вы ссылаетесь на ГС, то и ваш проект будет отнесен к отбросам интернета (а оно вам надо?).

Для этих целей, например, в WordPress можно использовать плагин WP-NoRef. Но этот плагин поможет вам закрыть от индексации только те внешние ссылки, которые будут проставлены из ваших статей или комментариев, а внешние ссылки из сайдбара или со счетчиков посещаемости вам придется закрыть от индексации поисковыми системами самостоятельно.

Многие оспаривают мнение о том, что статический вес утекает при таком раскладе, но это действительно так, во всяком случае это было бы вполне логично, а значит и рассчитывать стоит на худший случай.

Как продвигать сайт с учетом поведенческих факторов

Давайте теперь перейдем от ссылочной оптимизации к так называемым пользовательским факторам, которые могут как помогать продвигать ресурс, так и мешать этому процессу.

Как я уже упоминал чуть ранее, поисковики вначале опирались только на анализ внутренних факторов для правильного ранжирования, но затем им пришлось ввести и элемент ссылочного ранжирования, ибо выдача перестала быть релевантной введенному запросу из-за ушлых вебмастеров и оптимизаторов, которые просто-напросто заспамили все внутренние факторы.

Но ссылочное ранжирование, которое в определенный момент развития SEO в рунете было основным фактором и на который оказывали воздействие вебмастера и оптимизаторы, тоже на данный момент потеряло абсолютное доверие поисковых систем (ссылки стали предметом торговли и, следовательно, о релевантности выдачи, построенной только на основе ссылочного, говорить не приходится).

Хотя раньше было время, когда можно было вообще забить на внутреннюю оптимизацию и сделать упор только лишь на закупку ссылочной массы в созданных специально для этой цели биржах (Sape и т.п.). Время было очень простое и понятное, и именно на этом фоне появилось огромное количество SEO контор и фрилансеров (что-то вроде индивидуальных предпринимателей, берущихся за вознаграждение продвигать сайты в Топ), которые с энтузиазмом брались за любые проекты по любым запросам, лишь бы клиент подгонял денежки на закупку обратных ссылок.

В то время оптимизаторам вообще не надо было думать и заботиться о том, чтобы у клиента было хоть что-нибудь сделано в плане внутренней оптимизации и повышения юзабилити.

С помощью неограниченной закупки ссылочной массы можно было в Топ загнать все что угодно, но эти времена уже безвозвратно ушли и уступили место современным реалиям, когда поисковики всерьез вспомнили о внутренних факторах, не забыв и про внешние, ну и добавили что-то новенькое — стали смотреть, как ведут себя пользователи на сайтах и в поисковых выдачах по тем или иным запросам.

Сначала приведу определение пользовательских факторов (их иногда еще называют поведенческими) — это фактор ранжирования (для поиска это фактор ранжирования, а для оптимизаторов это уже будет фактор, влияющий на успешность продвижения, хотя все это одно и тоже, просто рассмотренное с разных точек зрения) учитывающий поведение посетителей в тех местах, где это можно отследить. Их учет нужен как критерий удовлетворенности ответом на запрос.

Оценка и учет пользовательских факторов — это своеобразная отрицательная обратная связь, которая позволяет поисковым системам очень четко ранжировать сайты в выдаче. Опираясь на их анализ, поиск может решить, что ресурс не интересен или мало интересен посетителям, в результате чего последний неминуемо будет понижен при ранжировании. В случае улучшения со временем отношения посетителей к этому ресурсу, он будет ранжироваться уже чуть выше.

Причем, следует учитывать то, что пользовательские факторы являются именно отрицательной обратной связью, которая призвана в первую очередь отсеивать плохие ресурсы, которые не интересны пользователям (попали в выдачу случайно и в результате накрутки ссылочного или переспама ключевыми словами). Но вот продвинуть сайт, делая упор только на улучшение или какую-либо накрутку поведенческих, у вас вряд ли получится.

Поисковики борются за максимальную релевантность выдачи (она должна давать ответы на введенные пользователями запросы). У них точно такая же конкуренция и борьба за посетителей, как и в нашем мире, уважаемые вебмастера. Правда борются они и делят всех пользователей рунета вкупе, а не как мы с вами…

Но общая картина все равно прослеживается — чем больше будет клиентов у поисковых систем, тем больше будет кликов по объявлениям контекстной рекламы (РСЯ или Адсенса) и тем больше будет у них доход.

Та же самая логика будет применима и к любому другому сайту, ориентированному на людей и на заработок посредством контекстной рекламы (ну, например, KtoNaNovenkogo.ru, который сначала зарабатывал в Рся, как было описано тут, а потом перешел на заработок в Гугл Адсенсе — здесь читайте мануал по этом делу).

Так вот, учет пользовательских факторов при ранжировании и стало последним трендом у них. Следовательно, у вебмастеров и оптимизаторов, пытающихся продвигать свои или чужие проекты, тоже возникла необходимость проводить пользовательскую оптимизацию. Но как это можно сделать и что учитывают поисковые системы при анализе поведения пользователей?

Тут можно ответить просто и односложно — ваш проект должен быть интересен посетителям и полностью отвечать на запросы, по которым вы хотите продвинуться. Кроме внутренней и внешней оптимизации вам придется еще озаботиться и таким понятием как юзабилити. Я уже попытался высказать свое видение решения проблемы его повышения (см. ссылку, расположенную чуть выше), хотя вопрос мне еще не до конца понятен и прозрачен.

Влияние поведения пользователей в поисковой выдаче

Но тут интересны еще и способы получения поиском информации по поведенческим факторам. Ну, во-первых, он анализируют поведение пользователей в выдаче, т.е. то, что ему вполне доступно. А что можно сказать при анализе поисковой выдачи по этому поводу?

В принципе, довольно много. Например, если сайт находится в Топ 10, но на него не совершается переходов или же пользователи сразу же после того, как перейдут на этот ресурс, возвращаются обратно в выдачу, то поисковые системы могут сделать справедливый вывод, что с данным ресурсом что-то не то, раз он не нравится посетителям. Через некоторое время он будет обязательно смещен из Топ 10 значительно в более глубокую …

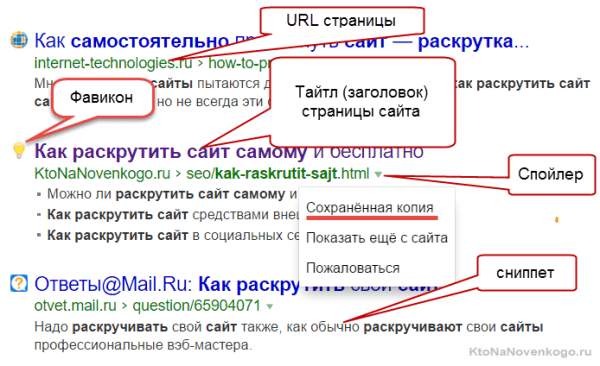

Если вы посмотрите на ту информацию, которая отображается для каждого сайта в выдаче, то очевидно и сами сможете прийти к тому выводу, что именно может повлиять на решение пользователей о переходе именно на него.

Конечно же, это содержимое мета тега Title, о котором мы тут довольно подробно поговорили. В предыдущей статье мы говорили о том, что в него обязательно нужно вставлять ключевые слова, по которым продвигается данная статья, и это правильно, ведь без надлежащей внутренней оптимизации контента попасть в Топ практически не возможно.

Но оказывается, что мало еще попасть в Топ по нужным запросам, нужно еще будет там удержаться. А вот в этом нам как раз и может помочь правильно составленный заголовок Title.

Т.е. у нас по-прежнему при написании статьи остается сверхзадача включить в его состав ключевые слова, но при этом сам текст должен быть написан в таком стиле, чтобы максимально притягивать к себе внимание пользователей поисковых систем и побуждать их перейти на ваш сайт. Как это сделать, подробно описано в статье приведенной выше.

Как видите, по мере развития алгоритмов поиска, задачи вебмастера и оптимизатора все усложняются и усложняются. Теперь мало будет просто перечислить в Title ключевые слова, нужно сделать это максимально броско и призывно, иначе в силу учета поведенческих факторов ваш проект может так же быстро вылететь из Топ 10, как он туда и попадет.

О том, как прописать этот мета тег для различных движков, вы можете почитать во второй публикации, ссылка на которую приведена в начале этой публикации.

Но не тайтлом единым… В поисковой выдаче кроме него отображается так же еще и небольшой фрагмент текста с вашего же ресурса, который призван показать пользователям Яндекса или Гугла, о чем, собственно, говорится в вашей статье. Этот фрагмент текста называется сниппет, и основная проблема при работе с ним заключается в том, что поисковики зачастую формируют его не на основе мета тега Description, а выбирая из текста наиболее релевантный запросу фрагмент статьи.

Хотя Google, например, по-прежнему зачастую формирует сниппет на основе Description, поэтому заполнять этот мета тег нужно в обязательном порядке и отдельно для каждой статьи. Текст в нем должен включать ключевые слова, по которым вы пытаетесь продвигать статью и быть привлекательным и призывным, ибо попав в сниппет он даст вам возможность бесплатно рекламировать свою статью в выдаче.

Как прописать его для разных движков я уже писал (как прописать Description в Joomla и в WordPress).

Конечно же, далеко не всегда сниппет будет формироваться на основе Description, но тем не менее, имея большое желание, можно попробовать повлиять на текст сниппета путем оптимизации небольшого фрагмента своей статьи. Само собой разумеется, что заморачиваться с этим стоит только для тех поисковых запросов, которые реально могут привести на ваш сайт много посетителей.

Для этого нужно будет создать искусственную ситуацию, когда во всем тексте статьи, созданный вами фрагмент покажется алгоритмам поиска наиболее релевантным для включения его в сниппет. Во-первых, под сниппет обычно берут текст размером от 160 до 240 знаков и именно на этот размер вам нужно ориентироваться при составление прототипа.

Во-вторых, прототип сниппета должен включать ключевые слова именно в тех словоформах (падежах, числах и т.п.), что и в поисковом запросе, по которому вы продвигаетесь.

Если говорить о выдаче Яндекса, то кроме сниппета и Title, на желание пользователя перейти именно на ваш ресурс может повлиять удачно сделанная иконка Favicon. Вроде бы пустячок, но CTR ресурсов, имеющих привлекательный Favicon, будет выше, нежели у аналогичных, но не обладающих этим преимуществом.

Желательно, чтобы прототип сниппета состоял из одного предложения, а в нескольких предшествующих и последующих ключевые слова вообще бы не встречались. В самом же кандидате плотность ключей должна быть очень высока.

При соблюдении этих условий создается ситуация, когда вы реально можете влиять на то, какой текст будет отображаться в качестве сниппета, а значит влиять и на пользовательские факторы, позволяющие чуть лучше или чуть хуже продвигаться по данному запросу.

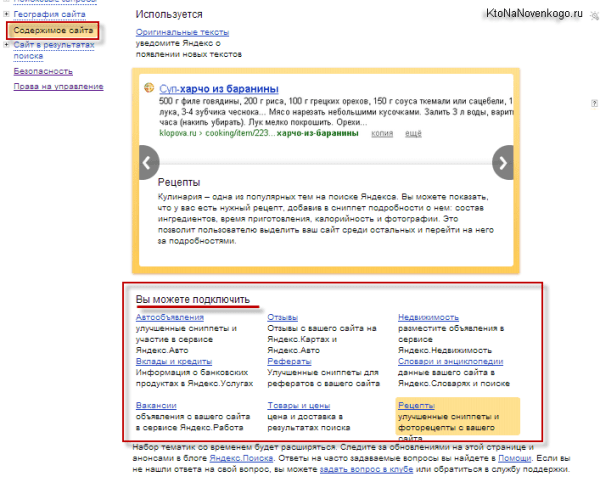

Если вы пытаетесь раскручивать коммерческий сайт, то обязательно загляните в панель Яндекс Вебмастера, ибо для некоторых тематик там у вас будет возможность добавить нужную информацию в сниппет, что очень сильно может повлиять на частоту перехода пользователей из выдачи.

В Яндекс Вебмастере вам нужно будет выбрать из левого меню пункты «Содержимое сайта» — «Вы можете подключить».

Как учитывается поведение пользователей на сайте при ранжировании

Но поисковым системам одной лишь информации о поведении пользователей в выдаче будет не достаточно для полноценного анализа, и поэтому они всеми правдами и неправдами пытаются и будут пытаться получить данные об их поведении именно на сайтах. Но как это сделать? Оказывается есть способы подглядеть.

Вы, наверное, и сами уже догадались, что такие данные поисковикам могут предоставлять их собственные инструменты аналитики (счетчики посещений Яндекс.Метрика и Google Analytics), которые, заметьте, распространяются совершенно бесплатно, а бесплатный сыр бывает только в …

Кроме этого, с высокой долей вероятности могу сказать, что Яндекс покупает у владельцев счетчиков посещений LiveInternet информацию о поведении пользователей на ресурсах, где они установлены, а ведь это подавляющее большинство проектов рунета.

Вы можете спорить, что LI информацию не продает, но на самом деле продает, причем не только Яндексу, но и некоторым крупным агрегаторам, предназначенным для автоматического продвижения, типа, Мегаиндекса, описанного тут, или Сеопульта.

Да это было бы и не логично с точки зрения бизнеса (не продавать столь востребованную информацию), ну, а афишировать они это ни в коем случае не будут, ибо резко упадет популярность этого безусловно полезного счетчика, анализируя статистику которого можно узнать много интересного о своем проекте.

Отсюда, кстати, можете сделать вывод — если вы занимаетесь созданием не перспективных на данный момент ГС (плохих сайтов, имеющих целью не предоставление полезной информации, а лишь исключительно заработок на продаже ссылок и т.п.), то не ставьте себе бесплатные счетчики посещений от известных сервисов, ибо это может помочь поисковым системам быстро вычислить ваш ГС и прикрыть его различными фильтрами.

Если же ваш проект ориентирован на людей (СДЛ) и вы уже провели все необходимые действия по улучшению юзабилити, то обязательно поставьте один из указанных мною выше счетчиков, чтобы поисковики знали насколько белый и пушистый ваш проект.

Но кроме данных собираемых счетчиками, которые вы сами установили на свои проекты, у поиска есть и другие способы оценки поведения пользователей на тех или иных ресурсах. Я говорю про Яндекс и Google бары, которые всовываются во все инсталляторы различных бесплатных программ типа Пунто Свитчера и ему подобных.

Тем самым поисковые системы имеют возможность получать данные о всех действиях владельца бара на различных посещенных им ресурсов. Тоже самое можно сказать и про Alexa Toolbar, который особенно активно используют пользователи в буржунете.

А Google даже пошел дальше и создал свой собственный браузер Хром, что естественно позволит ему еще лучше анализировать поведенческие факторы. Тут, кстати, в очень выгодных условиях находится стремительно набирающий обороты (в основном в буржунете) поисковик Bing, ибо его владелец MicroSoft имеет в своем распоряжении огромную статистику пользовательских факторов, собранных самым популярным браузером в мире — IE. Скорее всего, именно поэтому релевантность выдачи Bing получается более высокой, чем у основного конкурента, за счет чего Бинг и движется по нарастающей в буржунете.

Давайте теперь посмотрим, что могут анализировать алгоритмы в этих данных. Обычно говорят о таких вещах, как глубина просмотра (сколько страниц в среднем просматривает один пользователей) и время проведенное пользователем на сайте — подробнее про эти характеристики вы можете прочитать в этой статье о посещаемости и ее анализе. Для большинства ресурсов будет справедливым тот факт, что чем выше будут эти два параметра, тем лучше.

Но это не всегда так и я думаю, что поисковые системы очень выборочно подходят к анализу поведения пользователей. Любой сайт можно отнести к определенной тематике, кластеру или еще к чему-нибудь. Для этой группы поведенческие можно будет учитывать именно по отклонению от средней температуры по больнице. В теме вызова такси это будут отказы близкие к 100 процентам, а для новостных порталов — измеряться единицами процентов.

Тут, кстати, стоит отметить еще один важный пользовательский фактор, который может быть легко измерен и учтен — показатель отказов (он тоже подробно описан в приведенной выше статье).

Обычно показатель отказов измеряется в процентном отношении тех пользователей (от общего числа), которые пришли на одну из страниц вашего проекта, но не совершили перехода на другие и спустя короткое время покинули вас. Чем выше будет показатель отказа, тем сложнее вам будет продвигать такой проект.

Это особенно важно понимать и принимать во внимание при продвижении коммерческого сайта — составляя семантическое ядро нужно выбирать только целевые запросы, по которым вы будете в дальнейшем продвигаться. Если выбрать в качестве основного запроса для продвижения не целевой, но высокочастотный, то в результате, даже в случае успешного попадания в Топ 10, вы получите очень большой процент отказов (пользователи, не найдя ничего для себя интересного, тут же уйдут).

Но тем не менее вебмастерам, владеющим или только планирующим создавать СДЛ, пусть и не коммерческой тематики, следует озаботиться именно увеличением количества просмотренных страниц одним пользователем и постараться удержать его на проекте как можно дольше.

Анализировать эти пользовательские факторы применительно к своему ресурсу можно с помощью счетчиков посещений, а о том, как можно увеличить время проведенное пользователями на сайте и как вежливо предложить им посмотреть еще что-нибудь на сайте, я уже писал в статье про юзабилити.

Да та же самая грамотно созданная страница ошибки 404 (для Joomla, страница 404 для WordPress) может повлиять в лучшую сторону на поведенческие факторы и позволить продвигать сайт с большим успехом и меньшими усилиями.

Мелочей в этом деле нет. Вспомните и про внутреннюю перелинковку, о которой мы говорили во второй части данного мануала. Ведь кроме того, что она способствуют правильному распределению статического веса между страницами ресурса, она еще и может существенно увеличить глубину просмотра и время проведенное вашими посетителями на сайте.

Удачи вам! До скорых встреч на страницах блога KtoNaNovenkogo.ru

Источник: ktonanovenkogo.ru