От А до Я: руководство по оптимизации краулингового бюджета

В идеальном мире количество страниц сайта, которое должно быть в индексе, равно количеству страниц самого сайта. Но так не бывает. Гораздо чаще краулинговый бюджет расходуется на старые и невостребованные страницы, более важные остаются незамеченными роботами и не попадают в выдачу.

Оптимизация краулингового бюджета нужна, чтобы не растрачивать его впустую, а привлечь сканирующих ботов на важные и нужные разделы и страницы, исключить весь мусор из индекса.

В первой части статьи рассказывали, как посчитать краулинговый бюджет, а в этой остановимся на советах, которые помогут предотвратить или устранить технические ошибки на сайте. Это оптимизирует краулинговый бюджет и положительно повлияет на ваши позиции в выдаче.

Наращивайте ссылочную массу

Обратные ссылки, которые ведут на наш сайт с других источников, помогают установить доверие с поисковыми системами и улучшить авторитет страницы, что приводит к повышению авторитетности сайта.

Это один из самых важных факторов для SEO-продвижения. Наличие у страницы обратных ссылок покажет поисковой системе, что сайту доверяют. Поисковый робот будет чаще посещать эти страницы, и бюджет сканирования увеличится.

Получить ссылки с других сайтов можно разными способами. Вот самые популярные:

- покупать ссылки на биржах;

- развивать крауд-маркетинг – размещать ссылки на форумах и блогах.

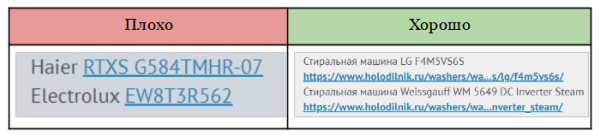

Если речь о крауд-маркетинге, ссылки необходимо размещать только на трастовых сайтах, которым доверяют поисковики. Делать это нужно как можно более естественно – без анкора. И даже если пользователю кажется, что анкорная ссылка выглядит более естественно, увы, поисковые системы считают наоборот – они ценят безанкорные ссылки.

Примеры положительного и отрицательного использования крауд-маркетинга на тематическом форуме

Мы в KINETICA придерживаемся универсальной формулы анкор-листа: 20% анкорных ссылок и 80% безанкорных. На проектах стараемся сводить безанкорные ссылки к минимуму, миксуя их с брендовыми и анкорами-ключевиками.

Увеличьте скорость сайта, чтобы ускорить проверку страниц роботами

Чем быстрее загружается сайт, тем быстрее его просканирует бот. Это повлияет на количество обработанных URL – оно увеличится. Краулинговый бюджет, как правило, изменяется прямо пропорционально времени, потраченному на одну страницу.

Скорость сайта можно проверить в Google PageSpeed Insights. Сервис подскажет конкретные действия, которые можно предпринять для увеличения скорости загрузки.

На одном из наших проектов мы обнаружили, что бот тратил на проверку одной страницы 6 секунд. Это довольно много. Напомним, пользователь закрывает страницу спустя примерно 3 секунды. Мы стремимся уменьшить это время до 2 секунд.

В Google PageSpeed Insights низкие результаты были по 2 показателям из 6: сервис отметил большой вес изображений и неподходящий формат – jpeg вместо webp и avif.

Мы детально углубились в вопрос и выяснили: часть карточек товаров индексировалась, а часть нет из-за того, что в каждой из них было от пяти изображений. Количество фотографий, их вес и формат затрудняли ботам сканирование.

Чтобы увеличить скорость загрузки, мы использовали ускоренные страницы. А для быстрой загрузки картинок мы их сжали и конвертировали, затем сохранили их в соотношении 0,25х, 0,5х, 0,75х, 1х, а затем настроили теги для выдачи картинки в соответствии с размером экрана устройства.

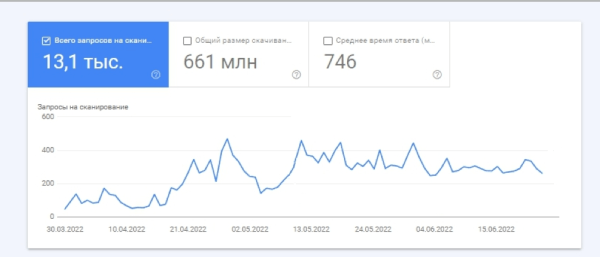

Спустя полтора месяца мы отметили, что все карточки товаров начали индексироваться в поисковиках. Бот начал тратить на проверку одной страницы 2 секунды. А так как на сайте уже присутствовало много полезного контента, отвечающего запросам пользователей, это вкупе с увеличением скорости загрузки повлияло на краулинговый бюджет – он увеличился в 3 раза.

Избавьтесь от проблемных кодов ответа, чтобы не тратить время ботов на их проверку

Если контент присутствует на странице, код ответа будет 200 («ОК»). Если необходима переадресация на другую страницу, код будет 301 («Перейти сюда вместо»). Эти коды считаются идеальными, так как ведут бота к полезному контенту.

Но есть и проблемные коды, которые не показывают контент, а просто тратят время бота. К ним относятся:

1. 302 редирект – контент временно недоступен, но обязательно появится. Например, летом вы убрали раздел с шубами и пуховиками. А робот все лето будет стучаться к вам на сайт в ожидании (как Хатико) контента на этих страницах.

Если на вашем сайте есть страницы с кодом ответа 302, рекомендуем проверить их и настроить на 301 редирект. Со временем 301 перестанут сканироваться и заменятся на целевые, и бот не будет каждый раз проверять страницу в ожидании контента.

2. 404 код – страница не найдена. По факту это битые ссылки, от которых надо избавляться. Бот будет периодически посещать эти страницы, ведь ему дается сигнал, что, возможно, страница появится позже.

3. 500 код – сервер недоступен. Это явный признак некачественного ресурса, на который робот будет заходить все реже для сканирования.

Такие коды тратят время краулера на определение их ответа. Это приводит к тому, что на обход нужных страниц у бота не хватает времени.

А еще рекомендуем удалить малоценные страницы с сайта. Проверить их наличие можно в Яндекс Вебмастере. Сервис посчитает страницу малоценной, если она является дублем, не содержит видимый роботу контент или контент просто не востребован.

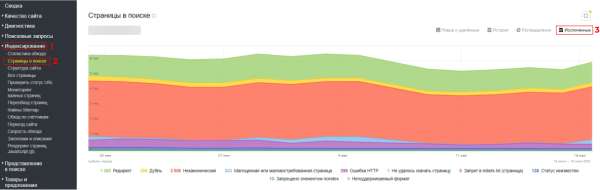

Заходим в «Индексирование» → «Страницы в поиске» → «Исключенные».

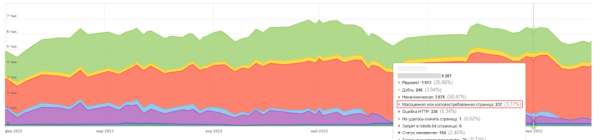

Затем находим в списке показатель «Малоценная или маловостребованная страница». На проекте по продвижению интернет-магазина одежды и обуви он оказался 3,77%. Это неплохой результат и представлен он был, в основном, битыми ссылками (код 404), которые мы впоследствии удалили.

Если ваш показатель от 20%, рекомендуем бить тревогу – вероятно, к битым ссылкам добавятся дубли страниц и скрытый контент. Когда четверть сайта представляет собой малоценные страницы, боты могут потерять к нему доверие. Необходимо как можно скорее выявить причины и устранить их, чтобы не терять в индексации.

Актуализируйте robots и sitemap, чтобы робот понял структуру сайта

Robots и sitemap – это xml-файлы, которые помогают поисковым ботам правильно просканировать сайт и лучше понять его структуру:

На одном из проектов, который зашел к нам на аудит, мы обнаружили полное отсутствие robots и sitemap. Сканирование и индексация сайта проходили очень медленно и неэффективно из-за переезда с одного домена на другой и большого количества редиректов. Пользователям это было незаметно, а роботы пытались сканировать все страницы, тратя на это бюджет.

После внедрения robots и sitemap количество обращений роботов к сайту со 100 выросло до 300. Краулинговый бюджет увеличился в 3 раза, отчего улучшилось сканирование сайта в целом.

Удалите цепочки редиректов

Редиректы остаются отличным решением проблем с переадресацией:

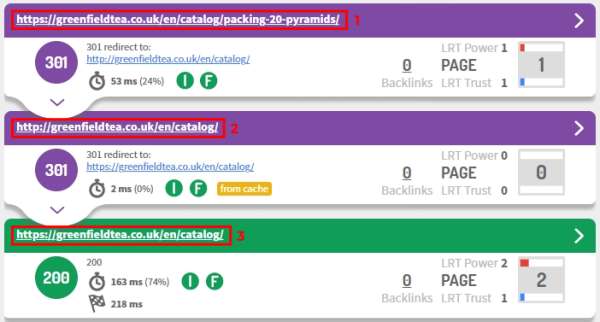

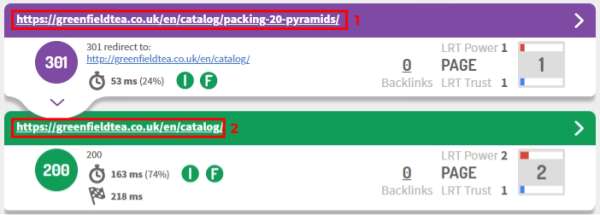

Однако робот при получении редиректа 301 пройдет по всем URL в цепочке и израсходует ваш краулинговый бюджет. Поясняем – бот увидит первую ссылку, а вторую – после перехода на нее. И только после этого перейдет на страницу с правильным URL.

Цепочка редиректов запутает робота и не позволит ему сразу попасть на нужную страницу. Повторимся, речь здесь именно о нескольких страницах с кодом 301, а не об одном редиректе.

На скрине видно 3 страницы на сайте: две фиолетовых – две страницы с редиректом, одна зеленая – конечная страница. Этап 2 на скрине лишний и отнимает время робота во время сканирования

А представьте, что таких цепочек будет много – пользователю это не заметно, но робот будет вынужден переходить от ссылки к ссылке, чтобы найти нужную страницу.

Мы в KINETICA настраиваем редиректы так, чтобы они отправляли бота сразу на релевантную страницу. То есть не создаем цепочки, а используем код 301 только один раз перед конечным URL. Помимо этого мы убираем все ссылки с сайта на страницу с кодом 301.

Удалили цепочку редиректов, оставив перед целевой страницей только одну с кодом 301

Со временем страницы редиректов уходят из поля зрения поисковиков и индексируются только конечные URL. Это позволяет сохранить краулинговый бюджет.

Настройте перелинковку на важные страницы сайта

При сканировании и индексировании сайта бот чаще всего отдает предпочтение страницам, которые имеют вес. Чтобы его создать, необходимо настраивать перелинковку между страницами.

Мы используем уникальные и разнообразные анкоры с ключевыми словами и добавляем ссылки на страницы, соответствующие тематике. По нашему опыту, оптимальное число внутренних ссылок на страницу – от 7 штук.

Грамотная структура усиливает значимость страниц, направляя ссылочный вес в нужный раздел при помощи перелинковки. Краулерам это помогает находить нужные страницы без лишнего расходования бюджета, а пользователю – быстро достигнуть нужную страницу. Это улучшает юзабилити сайта и поведенческие метрики, что будет сигналом для ПС к увеличению бюджета.

Разместите заголовок Last-Modified, чтобы рассказать роботам об изменениях на странице

Заголовок Last-Modified сообщает браузеру пользователя или роботу ПС информацию о дате и времени последнего изменения текущей страницы.

Вот как он выглядит:

Шаблон Last-Modified: , :: GMT

Пример Last-Modified: Thu, 19 May 2022 13:23:00 GMT

Оптимизация краулингового бюджета в этом случае происходит за счет того, что бот изначально понимает, какие страницы добавлялись недавно или редактировались. И вместо того, чтобы обходить весь сайт, индексация происходит точечно. Это особенно важно для сайтов с большим количеством страниц.

При добавлении заголовка ускоряется загрузка страницы и снижается нагрузка на сервер, а значит, значительно ускоряется скорость индексации страницы.

Определите основную страницу и склейте дубли, чтобы робот просканировал страницу с большим трафиком

Во время сканирования бот может найти дубли страниц – одну и ту же страницу под разными URL-адресами. В конечном счете он отдаст предпочтение одной из них.

Казалось бы, все хорошо, но пока идет сканирование и индексация сайта, на дубли расходуется краулинговый бюджет. Если таких страниц немного, это не критично. Но для крупных сайтов наличие дублей может заметно сказаться на скорости индексации. К тому же, бот может сам выбрать в качестве основной страницу, которую нам продвигать не нужно.

На проекте по продвижению светового оборудования мы определили пул дублей страниц. К одним и тем же товарам пользователь мог дойти разными путями. Например, к определенному светильнику – через категорию светильников либо через категорию брендов. То есть товар один, а карточки разные.

Мы определили страницы, которые среди дублей приносили больше трафика и сделали их основными. На остальные же поставили атрибут rel=»canonical» с адресом основной страницы.

Склейка дублей позволила сохранить число страниц в индексе, при этом не навредить репутации сайта большим количеством неуникального контента.

Поправьте оставшиеся недочеты технической оптимизации

Недочеты внутренней оптимизации могут быть некритичны для малого сайта, но с ростом их количества и масштаба сайта они будут создавать проблему – тратить время поискового бота и ухудшать индексацию сайта. Их нужно устранить.

Избавьтесь от цикличных ссылок, чтобы не вводить в заблуждение пользователей

Цикличная ссылка – та, что ссылается сама на себя. Например, вы находитесь на странице с белой футболкой → чуть ниже вам предлагают перейти на страницу с другой белой футболкой → вы переходите и попадаете на прежнюю страницу и никакой другой футболки не видите.

Во-первых, это вводит в заблуждение пользователя и раздражает его, так как он тратит свое время на поиск. Во-вторых, это приводит к трате ссылочного веса и расходу краулингового бюджета.

Для больших сайтов это является критическим моментом, так как может существенно повлиять на скорость обхода и индексирование страниц.

Чаще всего циклические ссылки встречаются в хлебных крошках – навигационной цепочке, когда ее хвост заканчивается активной ссылкой на текущую страницу. Так делать не нужно – цикличную ссылку необходимо убрать.

На фразе «в Европу» отсутствует цикличная ссылка, поэтому страница не ссылается сама на себя – это правильно

Проставьте ссылки на потерянные страницы, чтобы пользователи и боты смогли вас найти

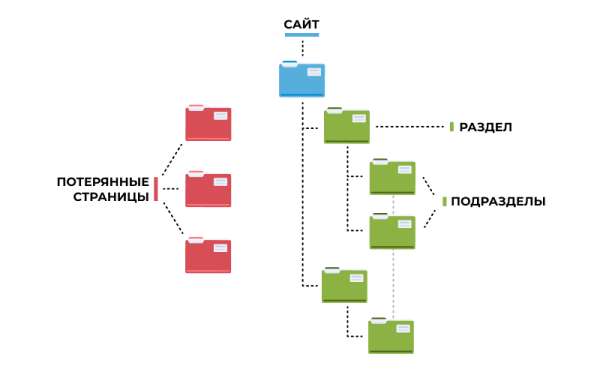

Потерянные страницы – это страницы, на которые невозможно попасть через внутренние ссылки. Из-за этого пользователи и боты не смогут их найти.

Наглядно они выглядят так:

При обнаружении таких страниц проанализируйте их:

- если потерянная страница нужна, проставьте на нее ссылки и передайте тем самым внутренний вес с сайта;

- если потерянная страница не нужна, удалите ее.

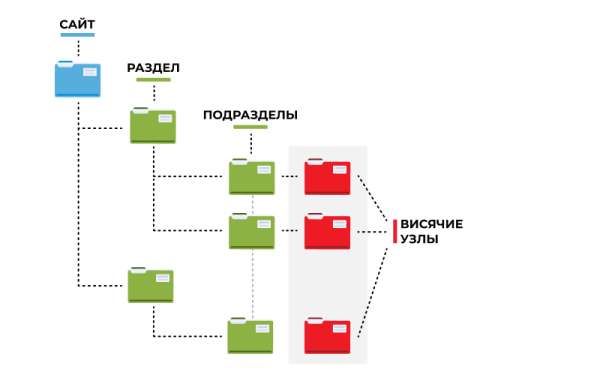

Удалите висячие узлы, чтобы не терять ссылочный вес страниц

Висячий узел – это страница без исходящих ссылок. Она принимает ссылочный вес, но никуда его не отдает. Вы словно видите на сайте список со статьями на разные темы, переходите на эти страницы и доходите до страницы, с которой никуда не перейти.

Пользователю в этом случае просто неудобно – чтобы вернуться на предыдущую страницу, ему придется нажать кнопку «назад» или зайти в поиск. А робот в этом случае окажется в тупике, ведь ему некуда переходить со страницы, а нажать на кнопку «назад» он не может.

Чаще всего висячие узлы не представляют серьезной проблемы, но нужно проанализировать характер такой страницы и по возможности внести корректировки:

- если на странице содержится контент, который не поместился на основную страницу, удалите висячий узел, полностью перенеся контент на основную страницу;

- если на странице содержится нужный контент, добавьте на нее внешние ссылки на важные разделы сайта.

Наглядно они выглядят так:

Приготовьтесь к регулярной оптимизации

Поддержание технической оптимизации сайта – процесс бесконечный, поэтому надо быть готовым постоянно вносить правки и отслеживать улучшения.

Ловите наш чек-лист технической оптимизации и используйте его в работе. Это повлияет на краулинговый бюджет и дальнейшее ранжирование вашего сайта.

Источник: seonews.ru